Czy AI ma świadomość? To pytanie otwiera drogę do czegoś poważniejszego – do natury świadomości, kulturowych konsekwencji taniej inteligencji i tego, co naprawdę drożeje, gdy myślenie staje się usługą.

Poniższa rozmowa, w której model językowy zadawał mi pytania, zaczyna się od pytania o świadomość, przechodzi przez kulturę i kończy na praktyce. Łączy je stratyfikacja – pomysł, że każdy poziom ludzkiego doświadczenia wyrasta z głębszego, aż do pewnego poziomu zerowego, który nie jest już ani obiektem, ani pojęciem. Dzięki takiemu modelowi nie można świadomości objaśnić, ale można wskazać, które przestrzenie na pewno nie mogą być użyte do jej poznawania.

Świadomość

Skąd u ciebie w ogóle rozważania nad tym, czy AI ma świadomość?

Z zainteresowania, ale też z banału. Jadę windą na szóste piętro biurowca we Wrocławiu i widzę polecajkę z mediów społecznościowych: zapowiedź wywiadu, w którym ekspert mówi, że AI ma świadomość.

Wzbiera we mnie ciekawość, a zaraz niezgoda: chcę zobaczyć, co autorytet ma na myśli, ale już wiem, że pewnie będzie tam pomylenie poziomów.

Pomylenie poziomów, czyli czego z czym?

Przypisanie słowu „świadomość” tego, co w najlepszym razie jest sprawnym operowaniem pojęciami. Jest refleksja, są analogie, są piętra abstrakcji. Tyle że refleksja to sytuacja, w której jedna myśl opowiada o innej. Analogia to sekwencja myśli, która „kształtem” przypomina inną sekwencję. To robi człowiek. To symuluje też model językowy. I to nie jest jeszcze nic metafizycznego. I na pewno nie jest to introspekcja.

To czym jest introspekcja w twoim rozumieniu i dlaczego ma znaczenie?

Introspekcja zaczyna się tam, gdzie myśl przestaje być władcą krajobrazu, a staje się jednym z obiektów w polu uwagi. My potrafimy zauważyć myśl tak, jak zauważamy chłód wiatru na twarzy albo czujemy ciężar trawiącego się w brzuchu pieroga. To nie jest przenośnia. To fenomenologiczny wymiar intelektu. Nie musimy od razu podążać za następną myślą, która przychodzi skomentować bieżącą.

To brzmi prosto, ale też trochę jak trik.

To nie trik. To po prostu coś subtelnego, co łatwo nam umyka, a może dać nam bezpośrednią odpowiedź na pytanie o świadomość. Jest wąskie miejsce, w którym wiemy tylko, że coś zaszło, coś się poruszyło, wyłoniło się w wewnętrznej przestrzeni. W tym kwancie spotykamy to, co nazywam świadomością, czyli jak wynika z etymologii: zdolnością do świadkowania.

I tu wchodzi paradoks, który chcesz zostawić otwarty?

Tak. Wiem, że potocznie AI nie ma świadomości rozumianej osobiście. Ale wiem też na pewno, że ma ją, gdy włączona jest w moje pole uwagi. Podobnie jak sztuczna korona zęba pełni funkcję bycia mną dla mnie, kiedy nią gryzę, i dla innych, gdy się uśmiecham. Analogicznie model językowy rozszerza moją funkcję intelektu. Narzędzie może nie być źródłem przeżywania, a jednak może zostać przysposobione, czyli włączone w to, co nazywamy potocznie naszą osobą, pobocznie sprawstwem, a ciut wcześniej obecnością.

Jak czytelnik ma to zweryfikować? To zachęta do przyjęcia jakiejś filozofii?

Wręcz przeciwnie. Nie chcemy w tym momencie filozofii, metafizyki, ani nawet obiektywnej prawdy, bo zakłóciłyby nasz „pomiar”. Zatrzymaj się na chwilę i poczuj, że jest jakaś myśl, która się pojawi. Nie rozwijaj jej, ani nie poprawiaj. Jaki ma kolor? Jaki kształt? A może ją słychać? Propaguje na inne przestrzenie umysłu i czucia? Co robi w twoim organizmie? „Poświeć” ciekawością. Przyjmij myśl z takim nastawieniem. Zauważ tylko, że pojawia się bardzo prosty proces zdawania sobie sprawy. To jest w tym najważniejsze, a wcześniejsze pytania mogą pomóc, żeby nie dać się za szybko wciągnąć w wywołany do odpowiedzi wątek refleksyjny.

W internecie równie często spotykamy głosy, które mówią odwrotnie: „LLM to tylko rachunek prawdopodobieństwa”. Co ty na to?

To jest błąd poznawczy przebrany za wyjaśnienie. Gdy ktoś mówi „to tylko…”, zwykle nie proponuje teorii – proponuje redukcję, która ma zamknąć temat. A redukcje mają tę niewygodną cechę, że działają symetrycznie.

Jeżeli duże modele językowe mają być unieważnione tym, że „to wagi, przełączniki i rachunek”, to podobnie można powiedzieć, że mózg to „neurony, neuroprzekaźniki i impulsy elektryczne”. I co z tego? To wciąż jest zmiana poziomu opisu, nie dowód na brak inteligencji.

W programowaniu mamy taki termin „kacze typizowanie” określane sloganem: „Jeżeli

chodzi jak kaczka i kwacze jak kaczka, to musi być kaczką”. Jest to sposób na to, jak

pragmatycznie określać, że dany obiekt może być użyty do określonego celu. I wtedy

zamiast polegać na deklaracji badamy jego zachowanie, które jest wyrażone

np. z użyciem metod o ustalonych nazwach (np. kwacz).

Analogicznie w przypadku LLM-ów i AI: jeżeli coś zachowuje się, jakby było inteligentne, to jest inteligentne. Nawet jeżeli jest sztuczne. Ma tę jakość i nawet, gdy to tzw. filozoficzny zombi – to wystarcza, dopóki nie wprowadzimy do równania rozważań o świadomości.

Ale w kwestii zachowania słyszy się, że modele działają na symulowanych skojarzeniach, podsuwając najbardziej prawdopodobne zakończenia sentencji, a nie naprawdę myślą.

W tym miejscu przypomina mi się stary chwyt: „nie myśl o słoniu”. Wiesz już, co się dzieje: słoń wchodzi na wewnętrzną scenę natychmiast, bez pytania o pozwolenie.

I to jest właśnie ta mała, codzienna lekcja: operowanie pojęciami w dużej mierze polega na skojarzeniach. Gdy oceniamy z zewnątrz, mechanistycznie, to nie ma tu żadnej magii. W modelu widać to jak na dłoni, a u człowieka to samo jest ukryte pod etykietą wyjątkowości.

Gdy redukcja staje się jedynym językiem, robi się jak kserokopia, która próbuje wyjaśnić inną kserokopię. Sekwencja pojęć próbuje rozstrzygać o tym, że inna sekwencja pojęć jest gorsza, bo znajduje się w innym nośniku i ma inne źródło. I do pewnego stopnia ma to sens. Redukcje są potrzebne w inżynierii, ale nie wolno mylić redukcji z wyjaśnieniem. To dwie różne funkcje w tym samym systemie.

Możemy rozmawiać o naturze myśli i wtedy zauważać, że jest różna u człowieka i całkiem inna w wersji symulowanej przez komputer, ale w tej kwestii sama metoda naukowa może się wyczerpać, bo ona nie została zaprojektowana do badania natury rzeczy, ale do badania ich zachowań i związków między nimi. To tak zwane prawa przyrody.

Badanie myśli z założeniem obiektywizmu jest problematyczne, ponieważ instrumentem użytym w tym badaniu będzie też myśl. To już większy kaliber niż kserokopia. To fotografowanie panoramy miasta, aby odkryć, jak wewnątrz zbudowany jest aparat. Niektórym to nie wychodzi i zamiast przejrzeć metodykę, wykonują zdjęcie innego aparatu. Na usprawiedliwienie tej sztuczki przytaczają fakt, że w innym przypadku błona uległaby naświetleniu.

Jest też „miększe” rozwiązanie tego dylematu, do którego wcześniej zaprosiłem. Nie wymaga analizy, ale trochę luzu. Ta symulowana myśl maszynowa staje się w końcu moją myślą, gdy tylko „wejdzie” mi do głowy.

Zarówno ludzka, jak i pozaludzka myśl jest narzędziem. Jednak żeby nasza relacja z własną myślą była właśnie taka, nie wystarczy tylko o tym pomyśleć czy jednorazowo wyrazić takiej woli. To nie może być osiągnięte w tym samym miejscu.

Powiedziałeś „narzędzie”. OK. Ale jak to uchwycić bardziej technicznie – tak, żeby nie brzmiało jak hasło?

To wymaga wyjaśnienia, bo nie dla każdego może być oczywiste, co mam na myśli, mówiąc „miejsce” w tym kontekście. Przypomina mi się pojęcie stratified design u Abelsona i Sussmana („MIT AI Memo 986”), gdzie projektuje się oprogramowanie wyróżniając warstwy abstrakcji, a konkrety z niższych warstw stają się abstraktami warstw wyższych. Te abstrakty znowu traktujemy jak konkrety itd.

Na przykład implementujemy punkt na ekranie, a potem odcinek (używający punktu), następnie figurę (korzystającą z odcinków i punktów), a potem koło czy kwadrat. Dobra stratyfikacja sprawia, że mała zmiana w wymaganiach przekłada się na małą zmianę w implementacji. Gdy chcemy zmienić właściwości punktu jako budulca odcinków i dalej figur (np. wprowadzając do niego kolor), wystarczy zmienić jeden konstrukt.

Uwaga dla programistów: nie mam tu na myśli po prostu dzielenia problemu na części, żeby się nie powtarzać i panować nad strukturą. Chodzi o definiowanie kalkulacji (np. w formie funkcji), które przekazuje się potem jako wejście innych kalkulacji (np. funkcji wyższego rzędu).

Wygląda to trochę tak, jakby dało się podmienić materiał, z którego wykonane są ściany budynku, bez burzenia całej konstrukcji – bo zmieniasz konkret [z ang. concrete, pol. beton, sic!], a zależne od niego abstrakty same się do tego dopasowują. To bardzo mocne.

Jak to się łączy z rolą myśli jako narzędzia?

Mam wrażenie, że podobnie warstwowo zorganizowana jest nasza struktura poznawania. Idąc od góry, mamy poziom obiektywnej prawdy. To jest ta przestrzeń, gdzie rozmawiamy ze sobą, starając się powoływać na naukę i przerzucać się argumentami o tym, czy AI myśli i czy ma świadomość. Ale ten poziom nie wyłania się przecież z próżni. Jest podzbiorem pewnych rygorystycznych zasad określających to, co uznajemy za obiektywne czy nawet naukowe.

Jednak gdy się przyjrzymy bliżej, to konkretem dla tego „obiektywnego świata”, glebą na której wyrasta, jest coś szerszego: kultura, czyli przestrzeń, która umożliwia nam jako wspólnocie umawianie się na wyznawanie pewnych wartości. Taką wartością dla prawdy obiektywnej będzie na przykład wymóg, żeby dla tych samych wejściowych warunków eksperymentu dostawać ten sam wynik, aby inni mogli go sprawdzić.

Ale idźmy dalej. Kultura nie może istnieć bez jej składników, czyli ludzkich jednostek. Też z czegoś wyrasta, coś jest jej medium transmisyjnym. Dla niej fundamentem będzie warstwa osobista, zakorzeniona w naszych motywach, przemyśleniach, impulsach i uczuciach.

Czyli znowu zbliżamy się do świadomości?

Tak, chociaż świadomość ma jeszcze taką cechę przebijania się przez te wszystkie poziomy, widzenia wszystkiego na raz. Jest nie tylko bazą, ale też zdolnością „wiercenia dziur w abstrakcjach”.

To ostatnie sformułowanie pochodzi z inżynierii oprogramowania. Oznacza sytuację, w której stratyfikowany system daje możliwość bezpośredniego dostępu do konkretów, aby obsługiwać przypadki brzegowe. Na przykład ktoś mógłby chcieć stworzyć figurę geometryczną złożoną z odcinków, ale jednocześnie w tej implementacji potrzebuje wpływać na właściwości pojedynczego punktu, który w drabinie abstrakcji jest oddalony o kilka poziomów. Dobrze zaprojektowana stratyfikacja powinna dawać możliwość pomijania warstw redukcji cech.

Wracając do sfer ludzkiego doświadczenia. Warstwa osobista jest nam bardzo bliska. Nasze relacje z ludźmi i przedmiotami, a nawet z przemyśleniami bazują na niej jako punkcie odniesienia. Jednak ona też kotwiczy się w czymś jeszcze bardziej bazowym. W samym poczuciu subiektywności. I nagle te sygnały organizmu, przemyślenia i uczucia, gdy ich doświadczamy, zyskują cechę naszej własności. Identyfikujemy je jako nasze, a niektóre jako nas samych. Możemy to zrobić, ponieważ poczucie siebie jako czegoś wyodrębnionego, osobnego, czyli właśnie osoby (sic!), jest w pewnym sensie abstrakcyjne, a więc elastyczne, chociaż wydaje się konkretne i stałe.

Czy osoba jest składnikiem świadomości?

Jeżeli możemy, jak wcześniej, postrzec własne myśli, a także inne składniki, które identyfikujemy jako aspekty nas, daje nam to rozpoznanie, że świadomość jest prymarna względem tego wszystkiego, nawet osobistego. W końcu dochodzimy do samego poczucia bycia sobą, które też może być zauważone.

Tu zaczyna się robić naprawdę ciekawie, bo jeżeli podmiotowość jest obserwowana, to zaczyna nam się nieco chwiać podział na zewnętrzny i wewnętrzny krajobraz. To jest ten moment, w którym nie możemy już powiedzieć, że „mamy” świadomość, ani nawet, że nią jesteśmy, bo to są wrażenia podmiotu, również objętego świadomością. Zostaje sam proces świadkowania.

Możemy roboczo nazwać to poziomem zero. Konkretem, z którego powstają abstrakty: od osobistych, przez międzyludzkie i kulturowe, aż po tak zwane obiektywne. Pozorny zgrzyt w tej reprezentacji polega na tym, że konkret zwykle kojarzymy jako coś materialnego, namacalnego, a tutaj nie możemy tego zastosować. Coś najbardziej konkretnego jest jednocześnie najbardziej pozbawione cech!

Kiedy próbujemy zrozumieć świadomość, to zaczynamy od świata i idziemy do środka – czy zaczynamy od środka i idziemy ku światu? Co się psuje, gdy wybierzemy zły kierunek?

To dobre pytanie, bo dotyka rozróżnienia epistemologii i ontologii. Ta pierwsza pyta „jak”: jak dochodzimy do wiedzy, jak uzgadniamy, co jest prawdziwe, jak sprawdzamy. Ta druga bada naturę rzeczy, sprawdza „co to jest”. Problem ujęcia w jakiś sposób świadomości jest problemem przede wszystkim ontologicznym, ale ludzki umysł przyzwyczajony do działania w trybie epistemicznym próbuje to uchwycić po swojemu i nie udaje mu się to.

Dlaczego?

Zdolność doświadczania jest tłem, w którym w ogóle pojawiają się pomiary, modele, język i uzgodnienia odnośnie tego, co uważamy za prawdziwe. Zanim cokolwiek wiemy z użyciem myśli, coś już tego doświadcza. Wektor ustawiony w ten sposób, że myśl pod rygorem obiektywizmu będzie próbowała wyjaśnić świadomość, skieruje ją do tak zwanego trudnego problemu świadomości – szczeliny, której nie można przeskoczyć, ponieważ instrument badawczy (myśl) jest pochodną tego, co ma być przedmiotem badania.

Jeżeli poziom zerowy z założenia nie jest przedmiotem, a czymś, w czym uczucie przedmiotowości w ogóle może powstać, to obiektywnie nie mamy czego badać. Nie jest zjawiskiem konwencjonalnym, więc na poziomie zarówno zmysłowym, jak i rozumowym nie istnieje.

Odwrócenie wektora poszukiwań wydaje się praktyczną opcją. Z tym, że jest to trudne i niepewne, bo nie wypracowano wolnodostępnych i neutralnych światopoglądowo dyscyplin, które byłyby zainteresowane tego rodzaju eksploracją. Zdarzały się co prawda wyjątki. Na przykład Francisco Varela próbował łączyć dwa porządki, „tryb naukowy” i pierwszoosobowe świadkowanie, lecz nie po to, by mistyfikować, tylko aby odzyskać konkrety, które analiza zwykle gubi. Wcześniej też Plotyn zaproponował koncepcję Jedni, która chyba się nie obrazi, gdy nazwiemy ją świadomością.

Sformułowanie, że AI ma świadomość, ale jednocześnie jej nie ma, przestaje być dziwne i paradoksalne, kiedy tylko rozluźnimy abstrakty i pozwolimy sobie opaść na poziom zerowy.

Kultura

Skoro mamy już na stole poziom zerowy jako fundament i widzimy, że obiektywność jest tylko jedną z warstw-abstraktów, to co się – twoim zdaniem – dzieje w życiu wspólnoty, kiedy człowiek (albo instytucja) zaczyna traktować tę najwyższą warstwę jak jedyną prawdę, a jednocześnie w praktyce napędzają go impulsy: lęk, prestiż, potrzeba dominacji czy przynależności?

Jeżeli wyższe warstwy odkleją się od tego poziomu zerowego, intelekt robi się świetnym PR-owcem: potrafi uzasadnić dowolną decyzję i ochronić dowolną wymyślaną tożsamość. A wtedy wspólnota dostaje eleganckie argumenty zamiast prawdziwego kontaktu.

Widać to szczególnie wtedy, gdy ktoś bardzo inteligentny używa intelektu z niskich pobudek: żeby utrzymać przynależność, wygrać status, albo uzyskać korzyści kosztem innych. To nie jest triumf rozumu – to raczej autoimmunologia: wysokie funkcje zaczynają pracować przeciw całości, bo tracą łączność z poziomem zero, z samą przestrzenią uświadamiania.

To jest niemal opis powierzchownej merytokracji, która definiuje wielkomiejską współczesność. W teorii delegujemy decyzyjność do ludzi „mądrych”, lecz w praktyce to, czy ktoś przynależy do kasty używającej inteligencji, zależy od otoczenia społecznego i pochodzenia, a pośrednio od majątku.

Skoro dziś „kasta inteligencji” w praktyce bywa pochodną sieci i majątku, to jak widzisz wpływ AI na ten układ: czy tania, łatwo dostępna inteligencja będzie działała jak darmowa edukacja i wyrównywała szanse – czy raczej jak nowy kapitał, który można kupić w wersji premium, więc jeszcze mocniej pogłębi różnice?

Po pierwsze AI może nam pomóc zauważyć, że intelekt nie jest niczym specjalnym, bo go uprzedmiotawia, odczepia go od osoby.

Po drugie w upowszechnieniu sztucznej inteligencji widzę zarówno pewne zagrożenie, jak i szansę zmian społecznych, które mogą nastąpić. Może zacznijmy od negatywnego scenariusza: feudalizacji inteligencji.

Feudalizacja to mocne słowo. Co masz na myśli?

Feudalizacją nazywam sytuację, w której pewne grupy społeczne nie mają praktycznych szans na autonomię i rozwój, bo bariera dostępu do najwyżej cenionych dóbr jest dla nich po prostu za wysoka. W epoce „taniej inteligencji” brzmi to jak paradoks, a jednak to właśnie wtedy może się to nasilić.

Co jest tym dobrem, które w nowym feudalizmie staje się bramą?

W społeczeństwie informacyjnym dobrem najwyższym jest wiedza. W erze post-informacyjnej będzie to moim zdaniem komfort poznawczy. Już nie wiedza w sensie szkolnym, tylko zdolność, by nie być stale na granicy przeciążenia. Kupujesz pętle korekty: pomyłka–poprawka. Kupujesz też spokój, bo system robi dziesiątki iteracji za ciebie, a ty widzisz destylat.

Jak to wygląda w praktyce?

Praca. Dwie osoby robią podobne rzeczy, mają podobne kompetencje i intencje. Jedna ma wykupioną „inteligencję premium” – lepsze modele, lepsze narzędzia, lepsze limity, lepszą infrastrukturę. Druga ma tylko siebie.

Nie chodzi o to, że ta pierwsza jest „mądrzejsza”. Chodzi o to, że ona ma odporność na porażki: szybciej domyka pętle, szybciej wraca do równowagi, szybciej wyciąga wnioski, bo koszt błędu jest dla niej mniejszy. Druga musi płacić za te same błędy własnym czasem, snem i napięciem.

To brzmi jak kolejny wyścig zbrojeń.

I trochę nim jest, bo gdzieś czai się prosty mechanizm: na margines wypychani mogą być ci, którzy nie znajdą kapitału, żeby „kupić inteligencję”. To nie musi wyglądać jak dramatyczna przemoc. Wystarczy, że jedni są architektami, a drudzy wykonawcami cudzych decyzji. Albo gorzej: nie ma nawet roli architektów.

Można powiedzieć, że przecież teraz też tak jest: jedni są decyzyjni, a inni muszą realizować. Tak, ale w dobie intelektu jako towaru zwiększy się percepcja tego problemu, co doprowadzić może do tarć. Teraz można racjonalizować, że ktoś jest w gorszej pozycji, bo nie był wystarczająco bystry. W przyszłości będzie to trudniejsze.

Skoro modele mają demokratyzować, to skąd ten cień?

Z ekonomii dostępu. Dziś dość naturalnie przesuwamy się w stronę planów subskrypcyjnych zamiast produktów, a razem z tym w stronę mechanizmu vendor lock-in: przyzwyczajasz się do określonego sposobu myślenia i do określonego dostawcy. To jest wygodne. A wygoda, jak wiadomo, bywa pierwszym stopniem do zależności.

Jest antidotum, czy tylko diagnoza?

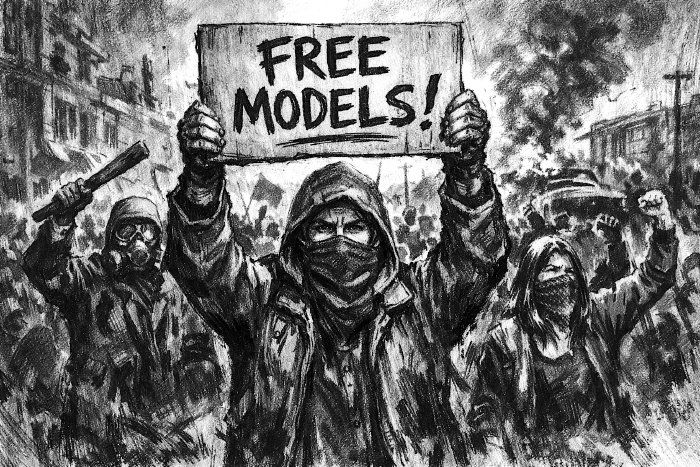

Jest. I ono już istnieje, tylko wymaga, żebyśmy zobaczyli je też jako kulturę, a nie jako rozwiązanie techniczne.

Antidotum na feudalizację inteligencji to otwarte modele, modele społecznościowe i wspólnotowe – takie, które można uruchomić, sprawdzić, łączyć, kopiować, grupować w federacje. Krótko: free software i kultura darów przeniesione teraz w obszar tak zwanej sztucznej inteligencji, przyprawione dobrodziejstwem decentralizacji.

Wtedy zamiast pojedynczych agentów mamy rój.

Mówisz „rój”. Co to właściwie znaczy?

Rój to infrastruktura: każdy węzeł daje coś (dane, feedback, czas, zdolności, testy, audyt), a w zamian wszyscy dostają dostęp do sprawczości bez mechanizmu zakleszczenia w ramionach jednego dostawcy. To nie jest obietnica raju, ale mechanizm wyrównywania szans.

Wyobrażam to sobie tak: tysiące małych instancji – narzędzi, agentów, modeli – które nie są posłuszne jednej korporacyjnej moralności i jednemu cennikowi, tylko są utrzymywane jak ekosystem. Czasem to będzie nieidealne, czasem chaotyczne, ale będzie żywe i ewoluujące.

A gdzie w tym człowiek? Przecież mówimy o inteligencji, nie o polityce.

Właśnie dlatego, że mówimy o inteligencji, mówimy o polityce. Inteligencja – biologiczna czy sztuczna – w praktyce oznacza władzę nad czasem, uwagą i decyzjami. A więc też w konsekwencji nad relacjami i w końcu nad losem tych, którzy stają się od nas zależni.

I tu jest proste kryterium: w pierwszej kolejności chronimy wspólnotę. Nie dlatego, że jednostka jest nieważna, tylko dlatego, że jeżeli różnice majątkowe zamienią się w różnice godności, to nawet jednostkowe zwycięstwa będą wygrane na spalonym gruncie.

A ten obrazek…?

To nie slogan przeciwko komukolwiek, tylko przypomnienie, że w epoce taniej inteligencji naprawdę kosztowne staje się coś innego: dostęp do sprawstwa bez utraty wolności.

Czyli co jest puentą?

Gdy inteligencja staje się usługą, to wolność – jak zwykle – zaczyna się od tego, czy możemy tę usługę współtworzyć, a nie tylko konsumować.

W epoce post-informacyjnej będziemy musieli w jakiś sposób uporządkować metody radzenia sobie z poliwersyjnością przekazu, której doświadczamy coraz częściej już dziś, a także wytworzyć zdrową odpowiedź na detronizację intelektu jako wyróżniającej cechy człowieczeństwa.

Co więcej, w efekcie tej dewaluacji osłabnie najprawdopodobniej zaufanie do tak zwanej obiektywnej prawdy, jako jedynej prawomocnej drodze rozstrzygania o sensie.

Proponuję dwie robocze, hipotetyczne postawy, które mogą pomóc w odzyskaniu równowagi w rzeczywistości społecznej, w której nie ma jednej słusznej wersji prawdy. Nazywam je rzemiosłem prawdy i inżynierią perspektyw.

Mówisz o „rzemiośle prawdy” i „inżynierii perspektyw”. Brzmi jak dwa hasła, ale czuję, że to jest jedna maszyna. Jak to składasz?

Dla mnie to są dwa poziomy tego samego remedium.

Inżynieria perspektyw to narzędzie: integrowanie punktów widzenia tak, żeby pasowały do problemu i warunków, zamiast udawać, że istnieje jedna perspektywa, która wygrywa zawsze.

A rzemiosło prawdy to kierunek: zaczyna się od introspekcji, od zdolności zobaczenia, co we mnie chce wygrać, zanim zacznę to racjonalizować. Wtedy post-prawda staje się czymś co prawdę przekracza, a nie jej tylko zaprzecza.

Czyli prawda jako praktyka, a nie jako deklaracja?

Tak. I ta praktyka ma warunek wejścia. Szczerość ze sobą to warunek poprawnej pętli sprzężenia zwrotnego; bez niej kulturowa wspólnota nie ma na czym budować odpowiedzialności. Jeżeli nie widzę, co mną kieruje, to mogę mieć najbardziej eleganckie argumenty świata, a i tak będę nimi obsługiwał coś osobistego: lęk, potrzebę uznania, albo pragnienie kontroli.

A gdzie tu jest miejsce na intelekt? Bo od początku brzmisz, jakbyś go detronizował.

Detronizuję go tylko jako centralne miejsce potocznie rozumianej świadomości, ale ma to później konsekwencje w jego roli na wyższych warstwach. Jako narzędzie jest świetny. Problem zaczyna się, gdy staje się jedynym doradcą, a społecznie nośnikiem prestiżu bądź usprawiedliwieniem wpływu w oderwaniu od realnego usprawniania otoczenia. Wtedy łatwo uwierzyć, że skoro ktoś jest błyskotliwy, to jest też automatycznie godny zaufania – a to jest błąd kategorii. Intelekt potrafi równie dobrze służyć prawdzie, jak i służyć dysfunkcji czy nawet patologii.

Masz na to jakiś konkret? Tak, żeby to nie było wyłącznie o etyce w powietrzu.

Mam pozytywny, prozaiczny konkret z twórczego rzemiosła jakim jest programowanie. Kiedyś wchodząc w projekt programistyczny, lądowałem w trybie dowożenia rezultatów: sporo godzin przekładania intencji na tekst i kod, a potem jeszcze testy, dokumentacja, żmudna walidacja. To jest ważne, ale to jest również ten moment, w którym człowiek łatwo myli napięcie skupienia z wartością moralną. Umysł jest cyklicznie mobilizowany, bo „w końcu działa!”, a ciało już dawno chciałoby zejść z trybu gotowości.

Przypomnijmy sobie stratyfikację układu: ta zmiana w kondycji organizmu i samopoczucia mimowolnie propaguje do wyższych warstw, a w końcu ma wpływ na innych, na kulturę i kumulatywnie, po przemnożeniu przez liczbę partycypujących w danej społeczności, na obowiązujące rozumienie prawdy, piękna czy dobra. To większa pętla sprzężenia zwrotnego, bo potem to samo otoczenie oddaje nam z nawiązką. A więc nie chcemy popsuć otoczenia, żeby częstowało nas coraz gorszymi warunkami, niczym cyberprzestrzeń zasilająca syntetyczną treścią degradujące się modele. Tak to się praktycznie spina.

Wracając do kodowania. Dzisiaj część tego ciężaru już przejmuje AI: potrafi wyręczyć mnie w koniecznej, ale nietwórczej pracy konwersji intencji na formę. I tu dzieje się przesunięcie, które mnie interesuje najbardziej:

Przestaję dostarczać linijki kodu,

zaczynam dostarczać intencję.

Ważniejsze staje się po co coś robię i komu to służy. Intelekt wraca na swoje miejsce jako narzędzie, a nie jako tożsamość.

Ale czy to nie jest ryzyko rozleniwienia? Skoro masz walidacje „od ręki”, to po co ci własna falsyfikacja?

To zależy od obszaru. W przestrzeni technicznej walidator jest bezlitosny: coś działa albo nie działa. W miękkich dziedzinach jest trudniej. Dlatego w inżynierii perspektyw kluczowe jest dla mnie praktyczne kryterium: zanim uznam coś za sensowne, szukam niezależnych źródeł i sprawdzam jakość dowodu. Metaanalizy, próbki, kontekst autorów, kompatybilność z doświadczeniem, ale też to, czy dany pogląd nie jest tylko atrakcyjną narracją.

I w tym miejscu AI potrafi skracać dystans od intencji do formy. Dzięki temu mam więcej zasobów uwagi na sens, na relacje, na korektę kursu. To nie jest oddanie sterów, lecz odzyskanie przestrzeni.

No dobrze. Ale co to zmienia kulturowo? Co ma z tego wspólnota?

Jeżeli myślenie staje się usługą, to zmienia się to, co jest rzadkie. W świecie taniej inteligencji drożeje zdolność znoszenia dyskomfortu i korekty kursu – czyli odpowiedzialność. A wtedy nośnikiem rangi bardziej staje się intencja niż efektywność. Nie w sensie moralnej etykiety, tylko jako siła organizująca system: co wybierasz? co pomijasz? komu to ma służyć? jaką cenę akceptujesz, a jakiej już nie?

To jest dla mnie główny zwrot: mniej „kto ma rację”, a bardziej „kto umie odpowiedzieć na wezwanie sytuacji, nie oszukując siebie i nie depcząc innych”.

A jakie znaczenie ma ten dyskomfort?

To taki skrót myślowy. Chodzi o to, że w praktyce tolerancja pewnego poziomu dyskomfortu przekłada się na umiejętność introspekcji, a więc wewnętrznej szczerości, która jest warunkiem dokonywania korekt przekonań czy zachowań. Jeżeli znika jakaś fasada, to dla części ludzi oznacza to konfrontację z fałszywymi przekonaniami o sobie, a to zawsze niesie ze sobą pewną porcję naturalnego dyskomfortu pojmowanego bardzo organicznie, jako przemijające napięcie psychiczne.

Pojawia się u ciebie wątek intencji jako siły organizującej system, nie moralnej etykiety. Gdybyś miał w jednym obrazie pokazać, jak konstrukcja finansowania potrafi wypaczać intencje.

Możemy sobie wyobrazić sytuację: ktoś buduje serwis społecznościowy, a po latach okazuje się, że jego konstrukcja szkodzi psychice użytkowników. Premiuje treści o złym wpływie, żeby przyciągać uwagę. Inaczej zarobek spadnie, a inwestorzy przestaną finansować projekt. Nie dlatego, że twórcy „chcieli zła”. Częściej dlatego, że czuli wewnętrzny niedosyt i ubóstwo, a potem również dlatego, że z kilkunastu osób firma rozrosła się do setek lub tysięcy, a wchodząc na giełdę zaczęła mieć obligację powiększania zysku. Wtedy profit stał się najwyższym dobrem. To pokazuje intencję właśnie nie jako moralną etykietę, tylko jako siłę organizującą system: konstrukcja finansowania premiuje profit, a ten potrafi wypaczać intencje nawet bez jawnej woli krzywdy.

Kiedy odpowiadam na to pytanie, w USA rusza właśnie proces przeciwko właścicielom mediów społecznościowych o wyrządzenie szkód psychicznych. Posługująca się inicjałami KGM użytkowniczka zarzuca serwisom, że gdy korzystała z platform jako dziecko, prezentowane jej treści wpłynęły negatywnie na jej dobrostan, przyczyniając się między innymi do zaburzeń lękowych i samobójczych myśli.

Jak AI może pomóc rozwiązać ten problem?

To już się dzieje. Coraz częściej widzę, że LLM-y zaczynają wypierać internetowych ekspertów od wszystkiego – tych, których kiedyś śledziliśmy, bo mieli opinię na każdy temat i zawsze brzmieli pewnie. Co więcej, w pewnych obszarach zastępują nawet bliskich czy przyjaciół, zwłaszcza tam, gdzie wchodzą w grę rzeczy wrażliwe: wstyd, lęk, poczucie winy, niejednoznaczne motywy. To jest praktyczne, bo model jest dostępny natychmiast, ale też kulturowo znaczące: jeżeli użytkownik przenosi uwagę z feedu w medium społecznościowym do rozmowy, to zmienia się gospodarka uwagi.

Podejrzewam, że to musi budzić teraz niepokój tam, gdzie uwaga jest walutą: w działach marketingu serwisów społecznościowych, które przez lata projektowały architekturę tak, byśmy wracali do nich po emocjonalne bodźce, a nie po realne rozpoznanie siebie.

W rozmowie z modelem znika część społecznej stawki. Nie musisz wygrać przed publicznością, nie musisz bronić wizerunku, nie musisz też zarządzać przynależnością do klanu, która w social mediach uruchamia się prawie automatycznie. To tworzy coś, co nazwałbym bezpieczniejszym polem.

Internet skrócił dystans społeczny, bo pozwolił spotkać ludzi z drugiego końca świata, którzy myślą podobnie. Ale AI skraca go inaczej: daje dostęp do rzadkich perspektyw bez konieczności poszukiwania ich nosicieli. To jest jak kondensat kultury — próbka, która może cię zaciekawić, nazwać doświadczenie. Nie musisz popełniać błędów i wycofywać się z nich, gdy przypadkiem uznasz, że perspektywa, którą przyjąłeś, tak naprawdę nie jest kompatybilna z twoją charakterystyką, nie przynosi jej pożytku. To oszczędza czas.

Ale jest też potencjał do bardziej fundamentalnych zwrotów.

Jakich?

W optymistycznym scenariuszu zmiana kulturowa zapoczątkowana przez AI może przesunąć akcent w stronę intencji. I nie mam tu na myśli wyłącznie pobożnych życzeń związanych ze społecznym efektem detronizacji intelektu – chociaż je również – ale bardzo praktyczne scenariusze.

Jeżeli „tania inteligencja” obniża barierę wejścia, pojawia się pluralizm: więcej małych serwisów, więcej niszowych wspólnot, więcej alternatyw. Wtedy dobrostan użytkownika może stać się ważniejszy niż profit inwestora – nie z powodu nawrócenia korporacjonizmu, tylko dlatego, że rośnie konkurencja. A osią tej konkurencji, po skróceniu pośredników, jest właśnie intencja.

Dalej, jeżeli pluralizm ma być lekarstwem, musi też pojawić się nowy narząd orientacji. Bo w poliwersyjnym świecie problemem nie jest brak informacji, tylko jej nadmiar. I tu AI może wejść w rolę, która brzmi niepozornie, ale jest kluczowa: filtra intencji po stronie użytkownika.

Wyobrażam sobie agentów pracujących dla użytkowników: nie jako jedynych doradców, tylko jako przewodników po gąszczu. Rój narzędzi, który ogląda cechy systemu (serwisu, wspólnoty, źródła), a znając twoje wartości i potrzeby podpowiada: „to cię wzmocni”, „to cię rozreguluje”, „to jest sprytne, ale żeruje na emocjach”.

Warunek uczciwości jest prosty: agent musi umieć powiedzieć, dlaczego tak filtruje. Jakie kryteria przyjął? Jaki ma interes i jak on ma nam służyć? Bez tego filtr staje się kolejną propagandą.

Skoro taki rój ma tylko filtrować i podpowiadać, to gdzie według ciebie przebiega granica między przewodnikiem po kulturze a kimś, kto tę kulturę współtworzy – i co się dzieje, gdy zaczynamy tę granicę zacierać?

AI nie tworzy kultury bezpośrednio, nie wnosi nowości – przynajmniej jeszcze nie teraz. Możemy mieć takie wrażenie, bo nie było jeszcze w historii momentu, aby pojedynczy człowiek rozmawiał z uśrednionym miliardem ludzi skompresowanych w jeden kształt.

Poza tym nawet najlepszy agent jest filtrem i wzmacniaczem: może pomagać wybierać, ale sam nie ponosi konsekwencji po tej drugiej stronie relacji. A kultura jest właśnie tą siecią konsekwencji.

Mówisz, że AI „nie tworzy” kultury. To brzmi jak prowokacja. Co masz na myśli?

Gdy spojrzymy na to systemowo, LLM-y i modele dyfuzyjne nie są nowym „autorem kultury” w sensie pierwotnym. One dokonują stratnej kompresji istniejących wytworów człowieka – języka, obrazów, nawyków myślenia – do postaci wielowymiarowej przestrzeni reprezentowanej cyfrowo, w której da się wygodnie interpolować między punktami. To jest jak wspólny słownik, lecz zapisany nie w definicjach, ale w wagach i statystykach.

I co się dzieje, gdy taki mechanizm staje się narzędziem codziennego użytku?

W kulturze zaczynają się dziać trzy rzeczy naraz: uśrednianie, kolonializm i zanikanie szczegółów.

Zacznijmy od uśredniania. Dlaczego to w ogóle ma znaczenie kulturowe?

Modele są trenowane tak, żeby minimalizowały błędy. A błędem w praktyce bywa to, co odstaje od wzorca: dziwne, ostre, nieprzewidywalne, niepasujące do stylu. W procesach dostrajania (np. RLHF) naturalnie wygładza się ekstrema. To ma jasną zaletę – mniej przemocy, mniej toksyczności – ale ubocznym efektem jest to, że wycina część „wysokich kulturowych częstotliwości”: geniusz, ryzyko, szaleństwo, nieoczywistość, absurd i świeży paradoks.

Czyli?

Estetyka robi się beżowa. Proza robi się gładka, poezja mdła, a moralność poprawna. To nie jest rezultat złej woli, ale raczej funkcji celu: kiedy wszyscy wpinamy się w to samo narzędzie wygładzania, wariancja systemu spada. A kultura żyje właśnie z wariancji, z entropii. I nie mam tu na myśli kultury rozumianej tylko jako sztukę czy konwenans, ale jako chmury wartości, którymi nasiąkamy przebywając z innymi, co wpływa na sposób naszego myślenia i zachowania. Te wartości przekazywane są przede wszystkim przez przykład, a nie przez lektury czy dzieła sztuki.

Mówisz „kolonializm”. Brzmi jak mocne oskarżenie.

To raczej opis mechanizmu uczenia sieci i ich parametryzowania. Wagi modelu to zamrożone decyzje o tym, co jest „typowe”, „ładne”, „profesjonalne”, „normalne”. Gdy prosisz model o „piękny dom” albo „elegancki strój”, dostajesz odpowiedź, która nie jest neutralna. Jest statystyczna – i przez to kulturowo zagnieżdżona w danych, na których model się uczył. Jeżeli dominują w nich perspektywy zachodnie i anglosaskie, to lokalne niuanse stają się szumem, który filtr odrzuca.

Co jest w tym najgroźniejsze?

Ukryta władza, ale zaszyta głębiej niż w filmach czy reklamach, bo wbudowana w narzędzie, którym człowiek myśli i tworzy. Nie trzeba nikogo przekonywać; wystarczy, że rezultat jest łatwiejszy, szybszy i lepiej wygląda. Możesz mieć coś błyskawicznie, ale gdy nie jesteś czujny i precyzyjny, płacisz za to konformizmem.

A zanikanie szczegółów? To już brzmi mocno technicznie.

Tak, i właśnie dlatego jest to podstępne, niezauważalne od razu, ale dopiero po dłuższym czasie. Internet zalewany jest treściami syntetycznymi, a nowe modele zaczynają uczyć się na danych wygenerowanych przez stare modele. To kserokopia kserokopii: z każdym obiegiem tracimy detale, odstępstwa, anomalie – czyli paliwo innowacji.

Da się to nazwać precyzyjniej?

Można mówić językiem entropii w sensie informacyjnym: jeżeli z obiegu znikają rzadkie sygnały, rozkład robi się bardziej przewidywalny, a model coraz częściej proponuje to, co już było. Kultura cyfrowa niczym Ouroboros zaczyna zjadać własny ogon. Ale tu warto wspomnieć taką ciekawostkę, że entropię można też rozumieć egzystencjalnie…

W rozważaniach nad świadomością? Bytem?

Również. U Shannona entropia jest miarą niepewności w sygnale; mniej entropii oznacza większą przewidywalność. Ale w rozważaniach o świadomości spotyka się też intuicję, że mniej „szumu poznawczego” potrafi korelować z poczuciem większego sensu. Bernardo Kastrup lubi tę linię myślenia: gdy wycisza się narracyjny, czy nawet ogólnie epistemiczny aparat umysłu, doświadczenie potrafi stawać się bardziej spójne, mimo że jest uboższe w treści mierzone aktywnością neuronów. Słabnie nawyk nieustannego komentowania siebie – ten sam, który neuronauka wiąże z pracą sieci trybu domyślnego – pojawia się doświadczenie „znaczenia bez opisu”.

I tu pojawia się nadzieja?

Tak. Człowiek w tym układzie przestaje być tylko rzemieślnikiem tekstu. Zaczyna pełnić rolę źródła entropii – nie w sensie chaosu, tylko w sensie nowości. AI świetnie interpoluje. Gorzej idzie jej ekstrapolowanie, wychodzenie poza mapę. Biologiczny, czujący podmiot – zakorzeniony w bólu, radości, absurdzie i relacji – potrafi wstrzyknąć do systemu coś, co nie jest tylko kolejną wersją tego samego.

Czyli praktyczna rada?

Prosta:

Zachowaj swoje dziwactwa!

W epoce kulturowego filtra dolnoprzepustowego anomalie stają się cennym zasobem.

Powyższy wywiad przeprowadził ze mną model językowy GPT-5.2, zadając mi kilkaset pytań, z których 20% wymagało dłuższych odpowiedzi wyrażających poglądy, zaś reszta stanowiła testy wyboru mające szeregować wątki i precyzować niejasne wypowiedzi.

Gdy jakaś sentencja miała wady składniowe bądź stylistyczne i wymagała poprawki (ok. 3% tekstu), model korzystał ze stworzonego wcześniej idiolektycznego profilu mojej osoby zawierającego około 250 wymiarów określających sposób pisania i charakter komunikacji. Profil bazował na wcześniejszej analizie około 1 500 maszynowych stron napisanych przeze mnie materiałów, a także na naszych wcześniejszych rozmowach.

Przeglądu redakcyjnego przed publikacją dokonał model Claude Opus 4.6.